Suchmaschinen haben das Leben der Menschen in vielerlei Hinsicht revolutioniert. Sie haben die Art und Weise, wie wir Informationen im Internet suchen und finden, grundlegend verändert. Doch was genau ist eine Suchmaschine und wie funktioniert sie? In diesem Artikel erfährst du alles, was du über Suchmaschinen wissen musst.

Was ist eine Suchmaschine?

Eine Suchmaschine ist ein spezielles Computerprogramm oder eine Webanwendung, die entwickelt wurde, um Informationen im World Wide Web zu finden. Das Prinzip ist vergleichbar mit einem riesigen digitalen Katalog, der Milliarden von Webseiten enthält.

Wenn du etwas in die Suchmaschine eingibst, durchsucht diese ihren Katalog (auch Index genannt) nach Webseiten, die deiner Suchanfrage entsprechen. Dieser Vorgang wird auch als Crawlen bezeichnet.

Die Suchmaschine verwendet Algorithmen, um die relevantesten Ergebnisse zu ermitteln und sie in einer geordneten Liste (auch Ranking genannt) anzuzeigen. Dieser Prozess basiert auf vielen Faktoren, einschließlich der Wörter, nach denen du suchst, der Relevanz und Qualität der Seiten, sowie anderen Seiten, die auf diese Seite verweisen.

Ein gutes Beispiel für eine Suchmaschine ist Google, aber es gibt auch viele andere wie Bing, Yahoo oder DuckDuckGo. Einige spezialisierte Suchmaschinen konzentrieren sich auf bestimmte Bereiche wie wissenschaftliche Publikationen, Bilder oder Videos.

Suchmaschinen Ranking in Deutschland und den USA

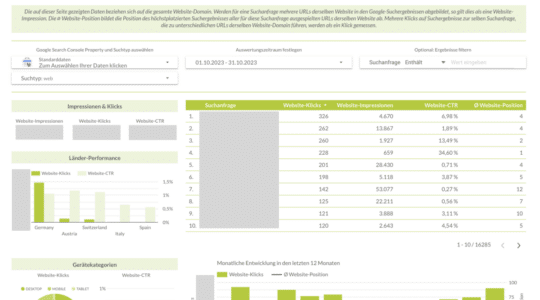

Die beliebteste Suchmaschine in Deutschland ist Google, die laut StatCounter im Mai 2023 einen Marktanteil von ca. 83% auf Desktop-Geräten hatte. Auch in den USA ist Google die beliebteste Suchmaschine mit einem Marktanteil von rund 82%. Auf Platz zwei landet im Ranking die Microsoft Suchmaschine Bing, gefolgt von Yahoo, DuckDuckGo und Ecosia.

Auf mobilen Endgeräten wie Smartphones oder Tablets dominiert die Suchmaschine Google – die Wettbewerber sind deutlich abgeschlagen. Die folgenden Übersichten geben einen Überblick über die Marktanteile der verschiedenen Suchmaschinen in Deutschland und den USA.

Suchmaschinen Ranking in Deutschland im Juni 2023

| Suchmaschine | Marktanteil Desktop | Marktanteil Mobile |

| 80,0% | 96,4% | |

| Bing | 12,6% | 0,8% |

| Yahoo! | 2,5% | – |

| DuckDuckGo | 1,6% | 0,8% |

| Yandex | 1,1% | 1,0% |

Suchmaschinen Ranking in den USA im Juni 2023

| Suchmaschine | Marktanteil Desktop | Marktanteil Mobile |

| 78,2% | 95,4% | |

| Bing | 15,0% | 1,2% |

| Yahoo! | 3,7% | 1,5% |

| DuckDuckGo | 2,3% | 1,7% |

| Yandex | 0,5% | 0,1% |

Die 10 beliebtesten Suchmaschinen weltweit

Laut NetMarketshare sind die weltweit wichtigsten und größten Suchmaschinen:

- Bing

- Yandex

- Yahoo!

- DuckDuckGo

- Baidu

- Naver

- Ask

- Ecosia

- Daum

In der folgenden Suchmaschinen-Liste findest du alle Informationen zu den Suchmaschinen und deren Marktanteilen weltweit.

1. Google

Google ist die bekannteste und am häufigsten genutzte Suchmaschine weltweit. Der Marktanteil lag 2022 bei rund 85%. Gegründet wurde Google 1998 von Larry Page und Sergey Brin. Die Suchmaschine nutzt komplexe Algorithmen und KI-Technologien, um die relevantesten Suchergebnisse zu liefern. Neben der grundlegenden Suchfunktion bietet Google auch viele zusätzliche Dienste wie Google Maps, Google News, Google Drive und mehr.

2. Bing

Bing ist eine von Microsoft entwickelte Suchmaschine, die 2009 auf den Markt kam. Obwohl sie nicht so weit verbreitet ist wie Google, bietet Bing einige einzigartige Funktionen wie eine tägliche Startseite mit wechselnden Hintergrundbildern, eine Video-Startseite und die Integration mit Microsofts digitaler Assistentin Cortana. Es wird oft als Standard-Suchmaschine auf Windows-Geräten verwendet und bietet ähnliche Funktionen wie Google, einschließlich personalisierter Suchergebnisse. Der weltweite Marktanteil von Bing lag 2022 bei rund 8,6%.

3. Yandex

Yandex ist die größte Suchmaschine in Russland und eine der Top 5 Suchmaschinen weltweit. Das Unternehmen wurde 1997 gegründet und bietet neben der Suchmaschine auch Dienste wie Yandex Maps, Yandex Music und Yandex Money an. Die Suchmaschine ist bekannt für ihre fortschrittlichen Algorithmen, die die russische Sprache gut interpretieren können. Der weltweite Marktanteil lag im Jahr 2022 bei rund 1,3%.

4. Yahoo

Yahoo (2,61%) wurde 1994 gegründet und war eine der ersten großen Suchmaschinen im Internet. Obwohl es in den letzten Jahren durch die Konkurrenz von Google und anderen zurückgedrängt wurde, bietet Yahoo weiterhin eine Suchplattform und verschiedene andere Dienste wie Yahoo Mail, Yahoo News und Yahoo Finance an. Yahoo Search wird inzwischen von Bing unterstützt.

5. DuckDuckGo

DuckDuckGo (0,9%) ist eine Suchmaschine, die für ihre Privatsphäre bekannt ist. Sie speichert keine persönlichen Informationen und verfolgt keine Suchanfragen oder Seitenaufrufe. Sie wurde 2008 gegründet und bietet auch eine anonyme Suche an, um die Privatsphäre der Nutzer zu schützen.

6. Baidu

Baidu ist die führende Suchmaschine in China und hat aufgrund der Beschränkungen für ausländische Dienste wie Google einen großen Marktanteil. Mit einer Vielzahl von Diensten, darunter Baidu Baike (eine Online-Enzyklopädie), Baidu Tieba (eine Online-Community) und Baidu Wangpan (eine Cloud-Speicherplattform), ist Baidu eine umfassende Plattform für chinesischsprachige Nutzer. Der Marktanteil weltweit liegt bei circa 0,8%.

7. Naver

Naver ist die dominierende Suchmaschine in Südkorea, ähnlich wie Google in den USA. Sie wurde 1999 gegründet und bietet viele Funktionen, darunter einen umfangreichen Nachrichtenbereich, eine Frage-Antwort-Plattform und sogar Webtoons (digitale Comics).

8. Ecosia

Ecosia ist eine ökologische Suchmaschine, die 2009 gegründet wurde. Sie spendet einen Teil ihrer Gewinne für die Wiederaufforstung und hat bereits Millionen von Bäumen gepflanzt. Die Suchergebnisse und Anzeigen werden von Bing geliefert.

9. AOL

AOL (America Online) war einst ein führendes Internetunternehmen in den USA und betreibt immer noch eine Suchmaschine. Obwohl seine Dominanz in den späten 1990er und frühen 2000er Jahren abnahm, bietet AOL immer noch verschiedene Dienste wie E-Mail, Nachrichten und Unterhaltung an.

10. Daum

Daum ist eine weitere beliebte Suchmaschine in Südkorea und ein Konkurrent von Naver. Sie wurde 1995 gegründet und bietet neben der Suchmaschine auch Dienste wie E-Mail, Nachrichten, Shopping und mehr an. Daum hat sich mit dem beliebten koreanischen Messaging-Dienst KakaoTalk zu Kakao Corp. zusammengeschlossen.

Die Entwicklung der Suchmaschinen seit den 1990er Jahren

Anfang der 90er Jahre erlebte das Internet einen regelrechten Boom. Immer mehr Menschen nutzten das World Wide Web und die Zahl der Websites wuchs exponentiell. Es entstand ein großer Bedarf nach einer Möglichkeit, das Internet zu „durchsuchen“ und Online-Inhalte auffindbar zu machen.

Die erste Suchmaschine war „Archie“, ein Projekt, das 1990 von drei Studenten der McGill University in Montreal, Alan Emtage, Bill Heelan und Peter Deutsch, ins Leben gerufen wurde. Sie programmierten einen Suchroboter, der das Internet durchsuchte, Informationen sammelte und in einem Archiv zusammenfasste.

Wenige Jahre später wurden zahlreiche kommerzielle Suchmaschinen entwickelt, darunter Lycos, Yahoo, Fireball, AltaVista, AOL und Excite. Die meisten dieser Suchportale existieren heute nicht mehr.

1998 wurde das Unternehmen Google gegründet. Ursprünglich 1995 als Studentenprojekt von Larry Page und Sergey Brin an der Stanford University gestartet, hat sich Google heute zu einem der größten Internetkonzerne der Welt entwickelt. Der Algorithmus war schon damals revolutionär, denn Google nutzte den so genannten „PageRank“, ein System, das die Linkpopularität einer Website bewertet. Je mehr vertrauenswürdige Links auf eine Website verwiesen, desto besser war die Platzierung im Suchmaschinenranking.

Heute wird in Deutschland das Wort „googeln“ als Synonym für „etwas im Internet suchen“ verwendet. Google ist eine der weltweit beliebtesten Suchmaschinen auf Computern, Laptops, Tablets und Smartphones.

Im Jahr 2023 beantwortet Google Suchanfragen mit einem ausgeklügelten Algorithmus und künstlicher Intelligenz. Mit dem revolutionären Rank-Brain-Algorithmus ist Google in der Lage, Fragen zu beantworten, die noch nie zuvor an eine Suchmaschine gestellt wurden.

Wie funktionieren Suchmaschinen?

Eine Suchmaschine ist ein mächtiges Werkzeug, um Informationen in den Weiten des Internets zu finden. Google, Bing, Yahoo und andere Suchmaschinen haben alle die gleiche Hauptaufgabe: Dir zu helfen, das zu finden, was du suchst. Aber wie machen sie das? Wie verwandelt eine Suchmaschine eine Reihe von Wörtern, die in die Suchleiste eingegeben werden, in eine Liste relevanter Webseiten?

Im Folgenden werden wir die Hauptkomponenten dieses Prozesses erläutern:

- Crawling

- Indexierung

- Ranking

1. Crawling

Crawling oder Webcrawling ist der erste Schritt, den eine Suchmaschine unternimmt, um Daten aus dem Internet zu sammeln. Es handelt sich im Wesentlichen um ein automatisiertes Durchsuchen, das von einem Softwareprogramm, dem so genannten Crawler oder Spider, durchgeführt wird.

Ein Crawler durchsucht jede Seite einer Website, liest den Inhalt und folgt den Links zu anderen Seiten innerhalb der Website oder zu externen Websites. Dieser Vorgang wird so lange wiederholt, bis der Crawler so viele Informationen wie möglich gesammelt hat.

Es ist wichtig zu beachten, dass nicht alle Seiten im Internet durchsucht werden. Manchmal blockieren Websites Crawler, indem sie bestimmte Regeln in einer “robots.txt“-Datei festlegen, die von Suchmaschinen respektiert wird.

2. Indexierung

Nachdem der Crawler eine Webseite besucht hat, muss er die gesammelten Daten irgendwo speichern. Hier kommt die Indizierung ins Spiel. Bei der Indexierung wird eine Kopie der Seite mit all ihren Informationen in einem riesigen Datenbankkatalog bzw. “Index” gespeichert.

Dieser Index ist wie das Inhaltsverzeichnis eines Buches, nur dass er Milliarden von Seiten enthält. Jede Seite wird kategorisiert und organisiert, damit sie später leicht gefunden werden kann.

Wichtig ist, dass Suchmaschinen nicht nur den Text einer Seite indexieren, sondern auch andere Elemente wie Bilder, Videos und weitere Mediendateien.

3. Ranking

Nun haben wir einen riesigen Index voller Informationen aus dem gesamten Internet. Aber wie bestimmt die Suchmaschine, welche Seiten für Deine Suchanfrage am relevantesten sind? Das ist die Aufgabe des Rankings.

Suchmaschinen verwenden Algorithmen, um die Relevanz und Qualität einer Seite zu bestimmen. Diese Algorithmen berücksichtigen eine Vielzahl von Faktoren, z. B:

- Die Anzahl und Qualität der Links, die auf eine Seite verweisen (Backlinks).

- Die Verwendung von Schlüsselwörtern (Keywords) im Inhalt der Seite.

- Die Struktur und das Design der Seite.

- Das Nutzerverhalten, z.B. die Verweildauer auf einer Seite.

Die Beeinflussung dieses Prozesses wird auch als “Suchmaschinenoptimierung” oder SEO bezeichnet. SEO-Praktiken zielen darauf ab, die Sichtbarkeit einer Website in den Ergebnisseiten der Suchmaschinen (SERPs) zu verbessern.

Welche Arten von Suchmaschinen gibt es?

Nicht alle Suchmaschinen funktionieren nach dem gleichen Prinzip. Im Folgenden stellen wir die wichtigsten Suchmaschinen-Arten vor.

Indexbasierte Suchmaschinen

Diese Art von Suchmaschinen durchsuchen das Internet kontinuierlich nach neuen oder aktualisierten Webseiten. Sie erstellen einen Index dieser Seiten, ähnlich dem Inhaltsverzeichnis eines Buches. Wenn Sie eine Suchanfrage stellen, durchsucht die Suchmaschine ihren Index und gibt die relevantesten Ergebnisse zurück. Ein bekanntes Beispiel für eine indexbasierte Suchmaschine ist Google.

Meta-Suchmaschinen

Meta-Suchmaschinen durchsuchen das Internet nicht direkt, sondern senden Anfragen an mehrere andere Suchmaschinen gleichzeitig und kombinieren dann die Ergebnisse. Sie sind nützlich, um einen umfassenderen Überblick über die Suchergebnisse zu erhalten. Beispiele sind Dogpile und Metacrawler.

Proxy-Suchmaschinen

Proxy-Suchmaschinen erstellen keinen eigenen Index, sondern nutzen die Indexierung anderer Suchanbieter. Bekannte Beispiele sind unter anderem Yahoo! und Ecosia, welche den Index der Microsoft Suchmaschine Bing verwenden.

Katalog-Suchmaschinen

Katalog-Suchmaschinen (auch Suchverzeichnis) stützen sich auf ein von Menschen erstelltes Verzeichnis von Websites, die in Kategorien eingeteilt sind. Sie sind besonders nützlich, wenn Sie nach einer bestimmten Art von Website suchen, da sie in der Regel qualitativ hochwertige Ergebnisse liefern. Ein Beispiel war das Yahoo!-Verzeichnis, das inzwischen nicht mehr existiert.

Semantische Suchmaschinen

Semantische Suchmaschinen nutzen künstliche Intelligenz und maschinelles Lernen, um den Kontext und die Bedeutung von Suchanfragen zu verstehen. Sie versuchen, genaue und relevante Ergebnisse zu liefern, indem sie die Absicht hinter einer Suchanfrage interpretieren. Ein Beispiel ist Wolfram Alpha.

Website Optimierung für Suchmaschinen

SEO oder Suchmaschinenoptimierung ist der Prozess der Verbesserung einer Website, um sie in den Suchergebnissen von Suchmaschinen sichtbarer zu machen. Es unterteilt sich in On-Page-SEO (Verbesserungen auf der eigenen Website, wie z.B. Optimierung des Inhalts und Verbesserung der Benutzerfreundlichkeit) und Off-Page-SEO (Maßnahmen außerhalb der eigenen Website, wie z.B. Aufbau von Backlinks). Eine effektive SEO-Strategie kann dazu führen, dass eine Website mehr Besucher erreicht und somit potenziell mehr Kunden gewinnt.

Du möchtest deine Website selbst für Suchmaschinen optimieren? Hier findest du die wichtigsten Einträge zum Thema SEO in unserem Lexikon und unsere beliebtesten Leitfäden.