Warum Eure Webseite bei Google nicht gefunden wird, kann viele verschiedene Gründe haben. Es kann beispielsweise Probleme mit der Indexierung, der Ladegeschwindigkeit oder dem Content geben. Unter Umständen habt Ihr die Webseite schlichtweg von den Suchmaschinen ausgeschlossen.

Warum Eure Seite in den Suchergebnissen bei Google nicht zu finden ist, möchte wir Euch nun erläutern, um den Fehler zu finden.

Webseite wird nicht bei Google in den Suchergebnissen angezeigt – Was bedeutet das?

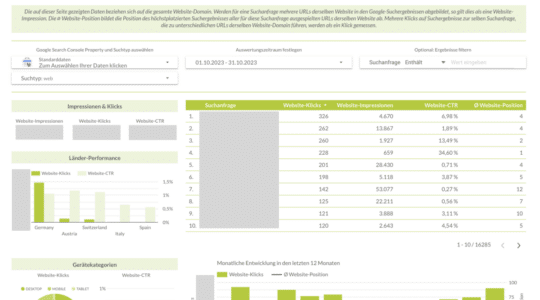

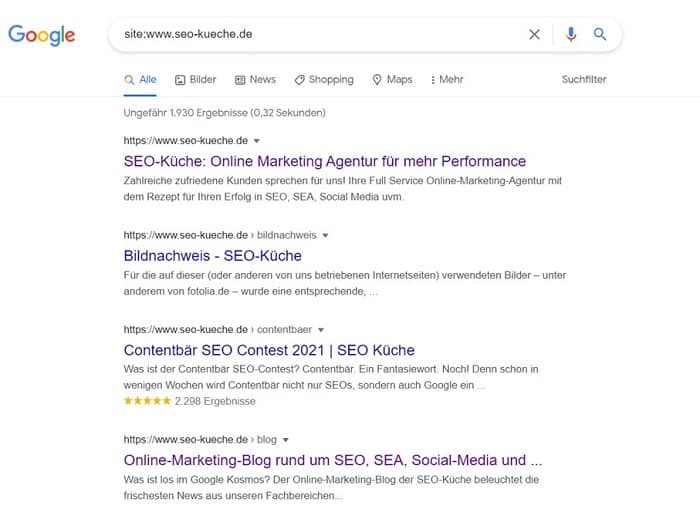

Im folgenden Beitrag möchten wir prüfen, warum Eure Webseite bei Google überhaupt nicht angezeigt wird. Hier soll es also nicht darum gehen, warum Google Eure Seite nicht auf den ersten Suchergebnisseiten (SERP) anzeigt, sondern warum sie gänzlich in den Suchergebnissen fehlt. Um zu prüfen, ob dies der Fall ist, müssen wir einen Befehl in der Suchzeile bei Google eingeben. Dieser Befehl gibt Euch Aufschluss darüber, ob Eure Seite bei Google angezeigt wird.

Gibt man den Befehl „site:“ ein und tippt anschließend den Namen seiner Domain mit oder ohne www ein, sieht man nach Betätigung der Enter-Taste welche Seiten und indexierten Unterseiten der eigenen Webseite bei Google angezeigt werden. Erscheint die Seite nicht, wird sie bei Google nicht angezeigt.

10 Gründe warum Google Eure Seite nicht findet

Die Gründe können vielfältig sein, warum Google Eure Seite nicht entdecken kann. In den meisten Fällen sind Webseite, Unterseite oder URL neu, sodass Google sie noch nicht kennt. Außerdem kann auch eine interne oder externe URL-Verlinkung fehlen, Google Probleme mit dem Crawling von neuen Seiten haben oder die Indexierung von Euch unterdrückt worden sein.

Des Weiteren kann ein Fehler in der Robots.txt vorliegen und es passiert sein, dass Ihr dem Crawler den Zugriff zu Eurer URL untersagt habt. Ebenso können Duplicate Content, Überoptimierung und qualitativ schlechter Content für Schwierigkeiten sorgen. Oder Eure Inhalte sind verfügbar, aber falsch kanonisiert worden (siehe auch Canonical Tag).

1. Indexierung wurde unterdrückt und Seite von Google ausgeschlossen

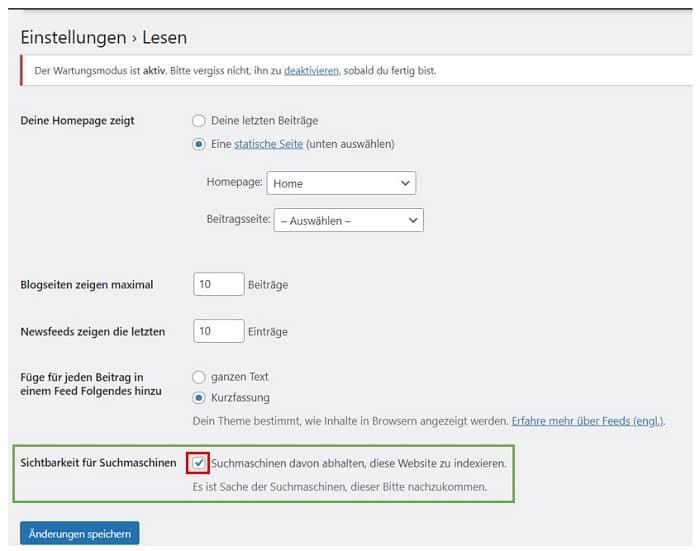

Wer das Content Management System (CMS) WordPress nutzt, kann dies durch einen Klick veranlassen und die Webseite von der Indexierung bei Google ausschließen. Die Suchmaschine hat somit keinen Zugriff auf Eure Webseite. Entweder dieser Haken war bereits gesetzt oder Ihr habt es selbst veranlasst.

Sobald Ihr dieses Häkchen unter „Einstellungen -> Lesen“ entfernt habt, wird Google Eure Seite in geraumer Zeit indexieren. Allerdings kann dies einige Zeit dauern, über die Search Console könnt Ihr nachhelfen und Google die Indexierung in die Wege leiten lassen.

2. Google per noindex oder Robots.txt ausgesperrt

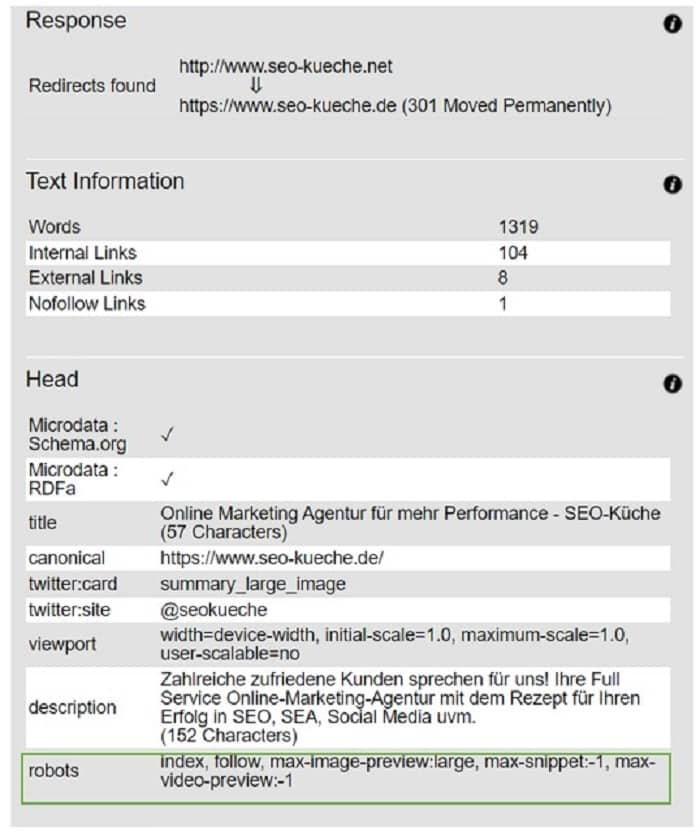

Unter Umständen kann das Meta-Tag „Robots“ den Wert „noindex“ tragen, wodurch Google an der Indexierung gehindert wird. Ihr müsst das Tag einfach entfernen; dies geht über das Content Management System oder manuell. Der noindex-Befehl ist im Head-Bereich der Webseite:

„<meta name=“robots“ content=“noindex“ />“

Mithilfe des Tools „Browseo“ könnt Ihr prüfen, ob der Wert gesetzt ist.

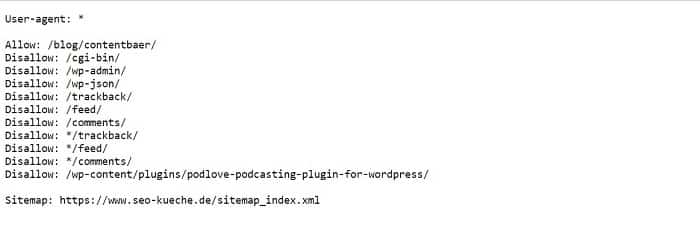

Ein weiterer Grund kann eine Datei namens Robots.txt sein, die sich in Eurem Root-Verzeichnis befindet.

„User-Agent: * disallow: /

werden die Crawler der Suchmaschinen ausgeschlossen. Das könnt Ihr einfach prüfen, indem Ihr hinter Eurer Domaine robots.txt eingebt: www.beispiel.de/robots.txt. Allerdings werden einige Seiten wie Duplicate Content, Paginierungsseiten und Chatseiten ausgeschlossen.

3. Google hat die Seite nicht indexiert

Nicht immer hat Google eine neue Webseite oder URL gleich indexiert, denn dies kann einige Zeit in Anspruch nehmen. Doch es gibt gute Neuigkeiten, denn man kann den Indexierungsprozess vorantreiben, indem man Google über die neue URL unterrichtet. Dies geht über die Search Console. Über die URL-Prüfung könnt Ihr sehen, ob die URL in den Suchergebnissen auf Google ist und die Indexierung beantragen.

So macht Ihr Google auf Eure URL aufmerksam:

- intern von wichtigen Hauptseiten verlinken.

- von einer externen Seite verlinken

- über die XML-Sitemap einreichen

- über das Tool in der Google Search Console übermitteln

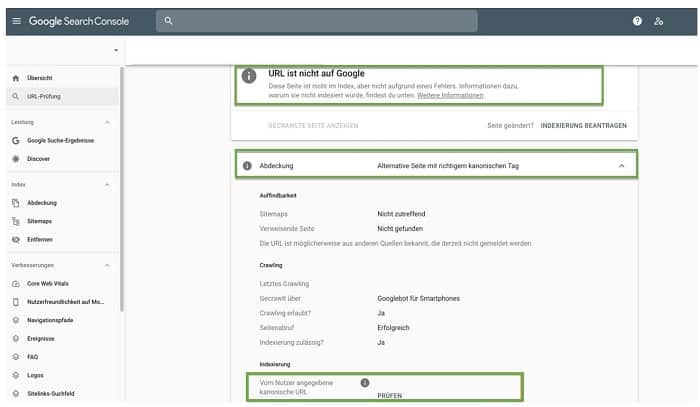

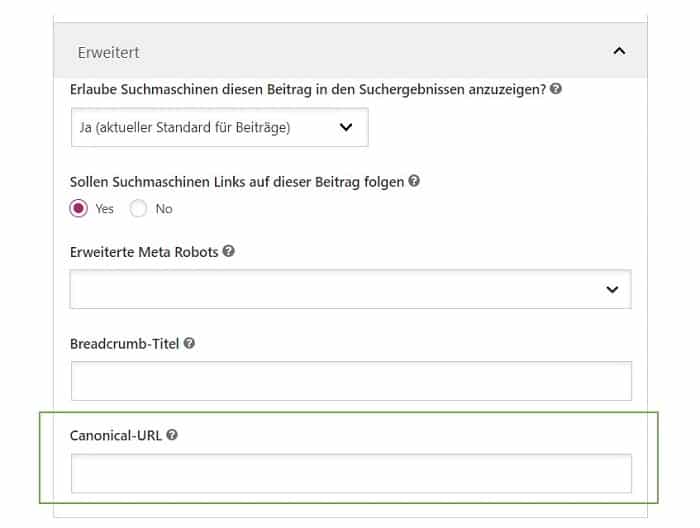

4. Probleme mit der Kanonisierung (Canonical Tag)

Mit dem Canonical-Tag (rel=canonical) könnt Ihr veranlassen, dass bei mehreren Unterseiten mit gleichem oder ähnlichem Inhalt nur eine einzige URL indexiert wird. Somit kann man Duplicate Content vermeiden. Auch bei diesem Schritt müsst Ihr über die Search Console die richtige Indexierung veranlassen. Zunächst überprüft Ihr, ob sich die URL der Unterseite im Index befindet. Google weist dann daraufhin, dass die URL nicht bekannt ist: „URL ist nicht bekannt“.

War dies nicht beabsichtigt, müsst Ihr prüfen, ob in Eurem Content Management System (CMS), ob die URL mit dem Canonical Tag rel=canonical auf eine andere Seite versehen wurde. Entfernt es an der entsprechenden Stelle und crawle die Seite nochmal über Google Search Console.

5. Duplicate Content

Wie bereits erwähnt, kann Duplicate Content ein Grund für das Nichtvorhandensein der URL in den Google-Suchergebnissen sein. Wird Content mit dem gleichen Wortlaut oder ähnlich nochmals erstellt und findet sich entweder auf der eigenen oder einer externen Seite wieder, handelt es sich um Duplicate Content. Ihr benötigt auf allen Unterseiten eurer Domain Unique Content, damit hier keine Indexierungsprobleme entstehen.

Ein beliebter Fehler sind vervielfältigte Produktbeschreibungen in Online-Shops, bei welchen der gleiche Text nur mit wenigen Abänderungen von Farbe oder Größe nochmals verwendet wird. Ein hilfreiches Tool ist Copyscape, es hilft Euch den Duplicate Content auf eurer Website aufzuspüren. Es ist auch als Plugin für WordPress verfügbar.

6. Die Webseite wurde über die Search Console entfernt

Es ist auch möglich, eine URL direkt über die Google Search Console zu entfernen. Möglicherweise ist Euch dies versehentlich passiert, dann müsst Ihr den Fehler rückgängig machen. Prüft über die Console, ob Eure URL erscheint oder nicht. Klickt auf Index und dann auf „entfernen“, erscheint keine URL, wurde sie nicht entfernt und es liegt ein anderes Problem zugrunde.

7. Überoptimierte Inhalte

Nicht nur schlechter Content, sondern auch überoptimierter Content kann für eine fehlende Sichtbarkeit sorgen. Keyword Stuffing oder Black Hat SEO werden von Google nicht gerne gesehen und werden daher abgestraft. Wer die Keywords im Titel, den Zwischenüberschriften, in jedem Absatz und allen Bildunterschriften verwendet, sorgt eventuell dafür, dass die Keyword Density viel zu hoch ist. Ein hilfreiches WordPress-Plugin wie Yoast SEO kann Euch bei der Überprüfung behilflich sein.

8. Qualitativ minderwertiger Content

Handelt es sich um qualitativ minderwertigen Content straft Google dies ebenfalls ab und indexiert URLs eventuell nicht. Euer Inhalt muss informativ, suchmaschinenoptimiert, vollständig und relevant für den Nutzer sein. Die Länge des Textes sollte unbedingt über 300 bis 600 Wörter liegen, ansonsten spricht man von Thin Content. Auf Deutsch heißt dies so viel wie „dünner Inhalt“, d.h. für Google sind die Webinhalte nicht ausreichend, um dem User einen Mehrwert zu bieten.

Bei der Erstellung von gutem SEO-Content spielen neben Aufbau, Umfang und Satzstruktur viele Faktoren eine wichtige Rolle. Wie Ihr gute SEO-Texte verfasst, könnt Ihr in unserem Leitartikel zum Thema nachlesen.

9. Änderung der Permalinks

Ändert Ihr die Permalinks, dann entstehen ebenfalls Probleme bei der Indexierung. Manchmal muss man den Permalink aus Gründen der Suchmaschinenoptimierung anpassen, jedoch muss darauf geachtet werden, dass die richtige Version indexiert wird und die alte entfernt. Durch 301-Weiterleitungen verschlechtert sich in gewisser Weise dein vorheriges Ranking, sofern die Seite bereits etabliert war.

10. Implementierung von SSL/HTTPS

Seit DSGVO ist die Verschlüsselung einer Internetseite besonders wichtig und zeigt dem Besucher, dass seine Daten vertrauliche behandelt werden.

Hier kann allerdings bei der Umstellung ein Problem entstehen, da Google die Version http:// und https:// als zwei verschiedene Domains betrachtet und indexiert. Ähnlich wie beim Wechsel der Permalinks ist auch hier ein Wechsel der URLs erfolgt. Deswegen müsst Ihr darauf achten, dass Google die richtige Version, d.h. die https:// indexiert und die andere Version http:// entfernt.

Häufig gestellte Fragen

Weiterführende Informationen & Quellen

- In der Google Search Console Hilfe erläutert Google nochmal, warum es zu Indexierungsfehlern und -problemen kommen kann.

- Das Buch „Suchmaschinen verstehen“ von Dirk Lewandowski gibt nochmals Einblicke, warum Seiten nicht bei Google angezeigt werden.

- Google Search Central erklärt nochmal, was bei der Indexierung zu beachten ist.

- SEO Südwest und T3N behandeln nochmals die Probleme, die bei der Indexierung auftreten können.