Am Freitag den 18.11.2022 war es wieder soweit: Die jährliche SEOkomm fand unter hoher Teilnahme in Bergheim bei Salzburg statt. Wir waren für euch dabei, haben alle Beiträge besucht und die wichtigsten Kernaussagen für euch in diesem Beitrag zusammengestellt.

Eröffnung

09:00 Uhr: Tobias Fox & Oliver Hauser

Pünktlich um 09:00 Uhr startete die Eröffnung mit organisatorischen Hinweisen für die Teilnehmer.

KeyNote von Bastian Grimm: „AI is eating the world (and Goolge)“

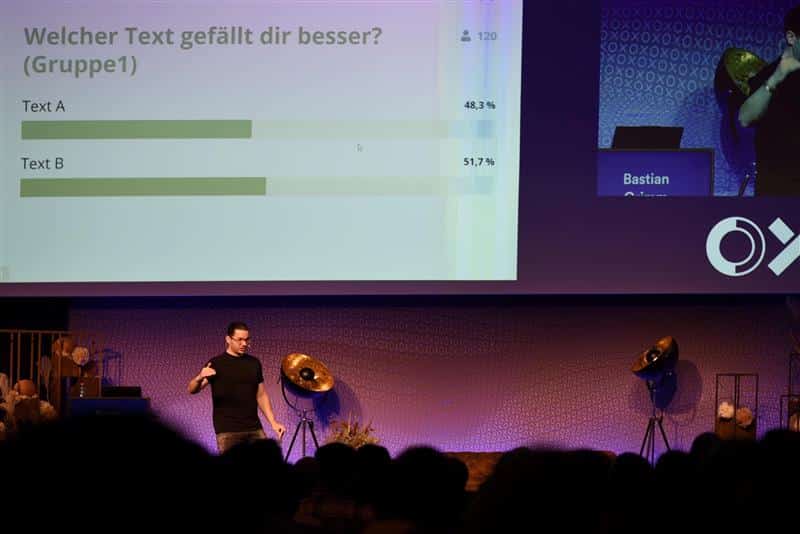

Bastian Grimm von der Peak Ace Agentur sprach auf der diesjährigen SEOkomm über AI. Als Vorbereitung platzierte Bastian Grimm unter den Sitzen der Teilnehmer einen Umschlag mit jeweils einem maschinell und einem menschlich erstellten Text. Die Teilnehmer konnten dann über eine Abstimmung wählen, welcher der Texte von der künstlichen Intelligenz erstellt wurde und welcher Text von einem Menschen geschrieben wurde.

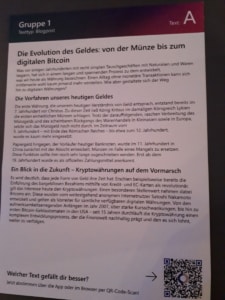

Unten findet Ihr die Fotografien von einem „Text A“ und einen „Text B“. Welcher wurde von einem Menschen und welcher wurde von einer Maschine geschrieben?

Ergebnis Testgruppe 1: Text B wurde von einer Maschine geschrieben – Text A wurde von einem Menschen geschrieben

Ergebnis Testgruppe 2: Text B wurde von einer Maschine geschrieben – Text A wurde von einem Menschen geschrieben

Ergebnis Testgruppe 3: Text B wurde von einer Maschine geschrieben – Text A wurde von einem Menschen geschrieben

Ergebnis Testgruppe 4: Text B wurde von einer Maschine geschrieben – Text A wurde von einem Menschen geschrieben

In nahezu allen Bereichen waren die Wahlergebnisse der Teilnehmer bei 50/50 plus-minus ein paar Prozentpunkten. Als Erkenntnis der Tests stand letztlich fest, dass es für die Teilnehmer nicht einheitlich möglich war, zu erkennen, welche Texte von Maschinen verfasst wurden.

Stichpunkte

- Für Menschen ist es schwer zu unterscheiden, welche Texte maschinell erstellt wurden und welche Texte von einer Maschine kommen

- Unternehmen investieren große Summen in die Entwicklung von KI zur Inhaltserstellung

- Auch bei der Bildgenerierung ist es für Menschen inzwischen nahezu unmöglich zu unterscheiden, welches Bild echt ist und welches Bild von Maschinen generiert wurde

- 60% des Internets besteht aus Duplikaten

- Dies benötigt sehr viel Speicherplatz und ist aufgrund des hohen Geld-, Energie- und Wasserverbrauchs nicht effizient

- Die Wahrscheinlichkeit ist hoch, dass Google und andere Suchmaschinen noch stärker versuchen werden, nur noch einzigartige Inhalte mit einem hohen Mehrwert zu indexieren

- Crawling ist teuer – Google weist daher immer wieder auf den Sitemap-Ping hin

- KI-Textgenerierungsmaschinen schreiben keine Texte. Sie generieren Texte aufgrund der zur Verfügung gestellten Parameter sowie den Trainingsdaten. Dies bringt auch Copywright-Probleme mit sich.

- Google und KI-Entwickler befinden sich in einem Wettlauf um die Erkennung von KI-Spam-Inhalten auf Seiten von Google und der Vertuschung / Optimierung von KI-Inhalten auf Seiten der Programmentwickler

- Google selbst versucht mit den jüngsten Updates KI-Spam zu erkennen und aus dem Index zu entfernen

- Domain-Autorität und der Markenname gewinnt in diesem Zuge wieder an Wichtigkeit für SEO

- Mit der Multisearch von Google wird versucht, dem visuellen Nutzerverhalten (erkennbar an der Entwicklung von TikTok) der jüngeren Generationen gerecht zu werden, da die Multisearch ebenfalls sehr visuell gehalten ist

- Die Herausforderungen für kleine Unternehmen im Marketing ist häufig die qualitative Inhaltserstellung von Grafiken etc. – hier können AI Tools helfen.

- Google wird weniger Seiten crawlen

- Pathways Language Model (PaLM) kann Witze erklären

Tooltipps:

- Riku AI

- Promtbase als Marktplatz von AI Promts

- Lexica.art

- bleedingedge.ai

- DALL-E AI

Kernaussage

Sich mit dem Thema KI zu beschäftigen wird für Unternehmen unausweichlich. Da KI-Programme die vielfache Erstellung von Inhalten sehr vereinfachen, wird es umso wichtiger, sich mit den Punkten zu beschäftigen, welche sich auf die Qualität dieser Inhalte auswirken. Denn: Für Suchmaschinen verursachen vielfach neue Inhalte eine Herausforderung in der Bewertung und daher ein Ressourcenproblem. Es ist daher davon auszugehen, dass Suchmaschinen noch stärker versuchen werden, nur noch wirklich wertvolle Inhalte in den Index aufzunehmen.

10:10 Uhr „Google Crawlmanagement Extreme“ von Darius Erdt und Jan-Peter Ruhso

In ihrem Beitrag gingen die beiden Redner auf Tipps und Tricks, sowie ihre Erkenntnisse und Erfahrungswerte zum Thema Crawling ein.

Stichpunkte

- Logfile-Analysen bringen zahlreiche Erkenntnisse zu Art und Weise wie Google die eigene Seite crawlt

- Laut Google sollten dies vor Allem große Seiten tun (große OnlineShops / Nachrichtenseiten)

- Bei kleineren Seiten reichen auch halbjährliche bis jährliche Analysen

- Vor- und Nach Relaunches

- Man sollte sich eher um die Crawling-Effizienz als um Crawling-Budget Gedanken machen

- Alle 200er Antwort-Codes verbrauchen Crawl Budget

- Alle 300er, 400er und 500er verbrauchen laut Google kein Crawl Budget

- Proaktive Steuerung über robots.txt, Sitemap und interne Verlinkung

- Crawling-Effizienz vermeidet E-Waste

- Mit E-Waste ist der unnötige Energie- und Wasserverbrauch für unnötige Crawls und Seitenaufrufe gemeint

- In einem Fallbeispiel konnte durch ein effizienteres Crawling 1,2 Tonnen CO2 bei einer einzelnen Webseite eingespart werden

- Linkmaskierung über PRG-Pattern erspart unnötiges Crawling

- Siloing hilft

- Das JavaScript „onHover()“-Event nutzen, um FlyOut Menüs nachzuladen

- TIPP bei Seiten, die zwar indexierbar sind, jedoch nicht in den Index aufgenommen wurden:

- Ein ehrlichen Qualitätscheck durchführen: Ist der Inhalt es überhaupt wert indexiert zu werden?

- Unnötige Inhalte deindexieren und vom Crawling ausschließen

- Sicherstellen, dass die wichtigsten Inhalte erfasst und aktualisiert werden können

Kernaussage

Ein proaktives Crawlingmanagement sorgt für eine optimale Verteilung der Crawlingressourcen, die einer Seite von Suchmaschinen bereitgestellt werden. Bei den Seiten, die für das Geschäft am wichtigsten sind, sollte das Crawl-Management proaktiv gesteuert werden. Statische Inhalte bestmöglich cachen. Unnötige Inhalte vom Crawling ausschließen.

Tool-Tipps:

-

- CrawlOptimizer

- LogRunner

- SearchConsole

- ScreamingFrog

10:10 Uhr – Webseiten-Performance-Monitoring und Optimierung bei OBI von Patrick Krebs

Im Vortrag berichtet Patrick Krebs über die 2019 / 2020 durchgeführten technischen SEO-Maßnahmen auf obi.de. Durch die Optimierungen von Bildern, CSS, Javascript und die Aktivierung von Browser-Caching konnte eine deutliche Verbesserung der Website-Performance erreicht werden.

Die Implementierung neuer Funktionen bremste die Website deutlich aus, was zu einem Rückgang der Conversion-Rate von 2,5 % führte.

In der Folge stellte Patrick die folgenden Tools vor, mit welchen sich wichtige Metriken üebrwachen lassen:

- Grafana

- Instana

- Lighthouse

- CLI

- Python

- DevTools

- Deployment Pipeline

- CRUX

10:10 Uhr – Was gibt es Neues seit der letzten SEOkomm? Von Sarah van den Berg

In dem Beitrag ging Sarah van den Berg rückblickend auf die Änderungen bei Google ein. Neben dem Helpful-Content Update ist seit der letzten SEOkomm in Salzburg sehr viel passiert.

Stichpunkte:

- Google legt einen stärkeren Fokus auf Produktrezensionen und Onlineshopping

- SEO-Performance wird seit neustem von Google bewertet

- 2022 liefen zwei Google Updates parallel

- Multisearch ist in 70 Sprachen verfügbar

- Das Helpful Content Update hatte nicht die erwarteten Auswirkungen, jedoch hat es spannende Diskussionen zum Thema „Was sind hochwertige Inhalte?“ angestoßen.

- SERP-Optimierung und Management hat weiterhin eine große Bedeutung.

- Google legt verstärkt Wert auf die proaktive Veröffentlichung von Best Practices

Kernaussage:

Das Jahr 2022 lieferte viele Erneuerungen bei Google die auch eine Vorschau auf das Jahr 2023 bieten. Sarah van den Berg hat abschließend den Vortrag mit den Worten „Unser Job bleibt spannend“ treffend zusammengefasst.

11:00 Uhr „Auditing JavaScript Websites“ von Martin Splitt von Google

In seinem Beitrag ging Martin Splitt von Google auf den Umgang von Google mit JavaScript auf Webseiten ein.

- Rendering ist Teil der Pipeline

- Jede Seite wird gerendert (CSS-Dateien, JavaScript Dateien, HTML, Bilder)

- JavaScript wird dabei ausgeführt

- JavaScript kann die Seite verändern

- Der Render-Output wird indexiert

Es wurde zudem auf Fälle eingegangen, in welchen Google Probleme hat, Seiten zu bewerten. Dies ist unter Anderem der Fall, wenn die Status-Codes fehlerhaft angegeben werden.

Stichpunkte

- Wenn „Other Errors“ in der Search Console auftauchen, kann man mit der „Viewed Crawled Page“ Tool ansehen

- dort kann man prüfen, ob Inhalte gerendert und somit auch indexiert werden konnten

- Wenn ein Inhalt nicht gerendert werden konnte, kann man unter „More Info“ prüfen, ob evtl. der Inhalt nicht gerendert werden konnte, oder JavaScript-Errors aufgetaucht

- In der Browser Console kann ich das gerenderte DOM-Objekt ansehen und prüfen, ob der Inhalt auch im gerenderten HTML in der Search Console verfügbar ist

- Tief verschachtelte Events, in welchen Inhalte von externen Webquellen nachgeladen werden, können eventuell nicht gerendert werden.

- Fehlerhaft verschachteltes Markup kann ebenfalls zu Renderingproblemen führen. Dies kann passieren, wenn JavaScript Inhalte falsch in den Quelltext lädt (z.B. in den <body> anstatt in den <head>)

- TIPP: Den Cookiebanner in ein separates JavaScript packen und dieses vom Crawling ausschließen, damit die Inhalte des Banners nicht gerendert werden.

Kernaussagen

Da JavaScript die Inhalte auf Seite verändern kann, werden von Google fortlaufend Anstrengungen unternommen, um das fertige DOM-Objekt zu bewerten. JavaScript hat Auswirkungen auf SEO. Die Google-Search-Console hat viele Möglichkeiten, um Probleme im Rendering zu erkennen.

11:50 „Sinnvolle Segmentierung im SEO“ von Sabine Langmann

Der Beitrag von Sabine Langmann beschäftigte sich mit dem Unterteilen von Webseiten und Crawlingergebnissen in Teilbereiche, um einen bestmöglichen Effekt für SEO-Analysen und betriebswirtschaftliche Entscheidungen zu erzeugen. Auch für die Fehlersuche ist eine Segmentierung hilfreich und erleichtert somit die Arbeit von SEOs.

Stichpunkte

- Segmentierung bringt mehr Übersicht in das Projekt

- Es wird eine genauere Fehlersuche ermöglicht

- Bessere Handhabung und gezieltere Maßnahmen möglich

- Segmentierung ist über Xpath, CSS Selektoren, RegEx, Logikketten

- Umsetzung über „unique identifyer“

- Speziell nach technischen Änderungen auf großen Seiten, hilft die Unterteilung bei der Fehlersuche

Kernaussage

Besonders bei großen Projekten, ist eine Segmentierung von Webseiten wichtig, um bestimmte Teilbereiche gut untersuchen zu können. Mit Segmentierung schaffen SEOs Strukturen und erleichtern sich somit die Analysen.

ToolTipps:

- Excel

- Crawler wie Screaming Frog

- Analyse-Tools wie Matomo

11:50 Uhr – „Multi-Domain-Strategie: So dominierst du die Suchergebnisse“ von Niels Dahnke

Niels Danke erläutert in seinem Vortrag die Möglichkeiten über SEO-Maßnahmen den Markt zu beherrschen und stellt innovative Multi-Domain-Strategien vor. Anhand von Praxisbeispielen zeigt Niels, wie unterschiedliche Bedürfnisse auf separaten Domains abgebildet werden können und welche Möglichkeiten zur Lead-Qualifizierung vorhanden sind.

Stichpunkte

- Hauptgründe für eine Multi-Domain-Strategie sind die Ausrichtung von Inhalten auf unterschiedliche Zielgruppen (bspw. Bosch grün und Bosch blau), Risikodiversifizierung und Segmentierung.

- Methoden: Aufspaltung nach Inhaltsarten, bspw. nach Downloads, Ausrichtung, Search Intent und Touch-Points der Customer-Journey.

- YMYL-Inhalte sollten immer ausgelagert werden

- Vorteile

- Erzeugung neutraler Marken

- Reputationsmanagement

- Preisgefühle des Marktes lassen sich beeinflussen

- Linkbuilding

- Schwierigkeiten

- viele Ressourcen notwendig

- ggf. schwächt die zweite Domain die Hauptdomain – eine klare Abgrenzung ist absolut notwendig

- Tipps

- Links durch Linktexte klar und sauber separieren (bspw. bei Links auf Infoseiten / Transaktionsseiten)

Kernaussage

Die Multi-Domain-Strategie hat stets die Dominanz der SERPS durch Beeinflussung von Märkten und Nutzergruppen zum Ziel. Eine thematische Abgrenzung nach Search Intent, Zielgruppen und Inhaltsarten ist dabei absolut notwendig.

11:50 – Ranking-Faktor Soft Skills: SEOs und Stakeholder managen von Stefan Fischerländer

In dem Beitrag von Stefan Fischerländer ging es um das Management aller beteiligten Stakeholder bei SEO-Maßnahmen. Dabei behielt er das größte Problem immer im Blick „Die Nicht-Umsetzung der SEO-Maßnahmen im Unternehmen.“

Stichpunkte

- SEO Maßnahmen sind vorrangig People-Driven und nicht Data-Driven

- Die richtige Einbindung der wichtigsten Stakeholder entscheidet über den Erfolg des Projekts

- Geschäftsführung

- Aufbereitete Daten

- Kommunikation mit CxO

- IT / Programmierer

- Ticket System

- Kommunikation mit Entwicklern

- SEO-Team

- Suchmaschinen Optimierung

- Daten Analyse

- Produktmanager

- Anforderung an das Projekt

- Steuerung der Umsetzung

- Geschäftsführung

- Decke alle benötigten Kompetenzen mit deinem SEO-Team ab

Kernaussage

Um „Nicht-Umsetzung der SEO-Maßnahmen“ zu verhindern benötigt man ein SEO-Team, welches alle Kompetenzen abdeckt. Des weiteren ist eine angepasste und hochwertige Kommunikation mit den jeweiligen Stakeholdern erfolgsentscheidend.

ToolTipps:

- Screaming Frog, Ryte

- Sistrix, Ahrefs

- Google Search Console

- Logfile Analysen

12:35 „Taking your SEO-Reporting to the next level: Effectively communicating with meaningful Reports“ von Aleyda Solis

In ihrem Beitrag – welcher auf Englisch gehalten wurde – ging Aleyda Solis auf die verschiedenen Tools und Möglichkeiten ein, Reportings zu erstellen und die Herausforderung, die wirklich wichtigen KPIs effektiv darzustellen.

Stichpunkte

- Reportings sollen eine Verbindung zwischen SEOs und Entscheidern schaffen

- Über 50% der SEOs präsentieren ihre Reportings nicht, sodass diese den Entscheidern nicht die Erkenntnisse liefern, die diese benötigen

- Über 70% der SEOs reporten monatlich

- Man soll nicht alles in Reportings packen, was man im Monitoring hat, sondern nur die KPIs in Verbindung zu den SEO-Zielen, welche die Kundschaft benötigt

- Man sollte alle Projektbeteiligten fragen, über welche Ziele im SEO-Prozess monatlich informiert werden soll

- Segmentierung der Reports für alle Projektbeteiligten mit deren wichtigen Informationen

- Für die Geschäftsleitung

- Für die SEOs

- Für die Content-Produzenten

- Welche Fragen sollen mit dem Report beantwortet werden?

- Unterteilung der KPIs in verschiedene Ziele

- Segmentierung der Reports für alle Projektbeteiligten mit deren wichtigen Informationen

- Datenquellen zu den KPIs nennen

- Reporting-Ansichten müssen leicht für Entscheider zu verstehen sein (keine Sichtbarkeitswerte etc. berichten)

- Bei jeder KPI, die reportet wird, soll die Frage darüber erscheinen, welche mit dem KPI beantwortet werden soll

- Man soll auch negative Entwicklungen berichten und darüber Informieren, warum dies so ist und was dagegen unternommen wird

- Keine Beschönigungen verwenden

- Kernaussage in der Überschrift des Reports (z.B. „Die Trafficsteigerung im Dezember betträgt 21% und erreicht damit nicht das 30% Ziel“)

Kernaussage

Gut organisierte und gut aufgebaute Reportings können mehr Ressourcen und Unterstützung von Entscheidern freimachen.

12:35 Uhr – „Search Console URL Inspection API – Besser als SEO Tools? von John Muñoz“

Die Seach Console URL Inspection API ist ein Must-have-Tool für viele SEOs. In dieser Session zeigt John Muñoz wie sich Reports und API beispielsweise über Google Sheets nutzen lassen. So lassen sich Fehler und SEO-Potentiale leicht identifizieren. Erklärt wird alles anhand anschaulicher Beispiele aus der Praxis.

Stichpunkte

- Mit der Google Search Console URL Inspection API lässt sich ein umfassendes SEO-Monitoring aufbauen

- Deep Dive Analysen von Sitemaps sind möglich

- Prüfung unkontrollierter und Identifizierung ineffizienter URLs

- Inspection API auch via Screaming-Frog nutzbar

Kernaussage

Die Google Seach Console URL Inspection API ist ein mächtiges Werkzeug, mit welchem sich Websites gut überwachen lassen. Durch die Kombination mit Google Sheets lassen sich zudem automatisierte Reportings erstellen.

13:10 Uhr bis 14:30 Uhr – Mittagspause

Egal ob vegan, vegetarisch oder herzhaft, für jeden Geschmack gab es eine umfangreiche Auswahl.

14:30 Uhr „Ranking Faktoren und klassisches SEO – wie viel davon ist für Dich noch relevant?“ von Marcus Tober – Semrush

Der Beitrag von Marcus Tober ging auf klassische Rankingfaktoren ein.

Stichpunkte

- Google erhöht die Frequenz von Updates, während die Auswirkungen gleichzeitig abnehmen

- Google erhöht die visuellen Anreize für E-Commerce Produkte (Ansicht „Popular Products“)

- Hierfür zu optimieren, bedeutet die Qualität, Frische und Menge der strukturierten Daten für Produkte zu erstellen

- Visuelle, kommerzielle und transaktionale Featured Snippets nehmen zu, während informelle und navigationale Featured Snippets abnehmen

- Mehr als 57% der Suchen führen zu keinem Klick, fast 25% beenden die Suche ohne geklickt zu haben (evtl. wurde die Antwort hier gleich von Google zur Verfügung gestellt)

- über 45% der Klicks entstehen durch die organische Suche

- Unter 5% enfallen auf die bezahlten Ergebnisse

- Auf Desktopgeräten klicken noch über 10% auf die zweite Seite der Suchergebnisse

- Auf Mobilgeräten unter 0,5%

- Die Anzahl der Google Bewertungen haben einen Einfluss auf die Platzierung in den lokalen Such-Ergebnissen

- Die durchschnittliche Bewertung in den Top 3 ist 4,3 in Google My Business

- Semrush kauft viele Daten von Service-Anbietern ein und stellt diese dann zur Verfügung

Kernaussage

Die Kernaussagen beziehen sich auf die Erkenntnisse hinter den gesammelten Daten von Semrush, welche wir in den Stichpunkten zusammengetragen haben.

ToolTipp:

- Semrush kombiniert die vielen gesammelten Daten und stellt diese als Erkenntnisse für Toolnutzer zu Verfügung

14:30 Uhr – „Relaunch mit drei SEO-Wetten: Wie klug ist der Google Algorithmus wirklich?“ von Nina Roser

In dieser Session geht Nina Roser auf ein konkretes Fallbeispiel eines Relaunchs ein und thematisiert in Form von Wetten drei bekannten SEO-Annahmen:

- Holistische Landingpages ranken besser als einzelne LPs in Strängen nach Keywords.

- Exact Match war gestern, Google versteht Sinnzusammenhänge im großen Stil.

- Qualität statt Quantität – Content mit Mehrwert gleicht die große Menge an gelöschten Seiten aus.

Stichpunkte

- Im Rahmen des Relaunchs wurde der URL-Korpus von 45.000 auf nur 4.500 reduziert

- Es wurden holistisch aufgebaute Standortseiten erstellt, welche verschiedene Standorte auf einer Seite abdecken sollten.

- Ergebnis von Wette 1

- Holistische Landingpages funktionieren für lokale Suchanfragen in begrenztem Umgang

- Ergebnis von Wette 2

- Exact Match ist notwendig, benötigt aber auch eine separate URL, um maximale Relevanz zu erreichen.

- Ergebnis von Wette 3

- Qualität zahlt sich immer aus, durch die Aufwertung der Inhalte konnte die Anzahl der gelöschten Seiten ausgeglichen werden.

Kernaussage

Holistische Landingpages ranken besser als einzelne Landingpages in Strängen nach Keywords. Exact Mach ist nach wie vor wichtig, funktioniert aber nur, wenn für das entsprechende Keyword-Set eine separate URL existiert. Die Qualitätsmaximierung sollte vor allem im Rahmen eines Website-Relaunchs an erster Stelle stehen.

15:20 Uhr LinkedIn Boosting – So funktioniert SEO auf LinkedIn von Britta Behrens

In dem Beitrag von Britta Behren konnte man einen umfangreichen Einblick LinkedIn erhalten und welche Vorteile die B2B-Plattform bietet.

Stichpunkte

- LinkedIn ist eine mächtige Suchmaschine

- LinkedIn ist die B2B-Plattform Social Media Plattform

- Unternehmen profitieren von der Autorität von LinkedIn bei Google

- Dein Content im Profil ist die Grundlage für eine bessere Auffindbarkeit

- 5 Der Algorithmus vom Newsfeed entwickelt sich permanent weiter

- Nutze die Content- und Creator-Analytics Daten

- Setze Corporate Influencern für deine Company Pages ein

Kernaussage

LinkedIn ist gerade im B2B Bereich eine starke Suchmaschine, die viele Möglichkeiten bietet. Unternehmen können mit sich ständig weiterentwickelnden Social-Media und SEO-Strategien große Erfolge erzielen.

15:20 Uhr „E-Commerce-SEO meistern – So gewinnt man als kleinerer Shop gegen Amazon, Zalando & Douglas“ von Stefan Vorwerk

In seinem Vortrag ging Stefan Vorwerk auf die Möglichkeiten für kleine Spezialshops ein, gegen große Dominatoren wie OBI, Amazon, Ebay und Idealo zu bestehen.

Stichpunkte

- DESI ist Sichtbarkeitsindex für Deutschen E-Commerce

- Die organische Suche wird immer schwerer für kleine Shops

- Große Marken dominieren die Suche und werden immer sichtbarer

- Kernfrage „Was ist eure Daseinsberechtigung in einer Amazon-Welt?“

- Individualität & Fokus

- Datenmenge & Qualität

- Featured Snippets steigern die Klickraten signifikant – wie bekommt man diese Featured-Snippets?

- Inhaltsverzeichnis

- Content von A-Z

- Einfache Lösung anbieten

- Strukturelemente

- Alternative Lösungen aufzeigen

- Antizipieren (Mögliche Probleme nen)

- Deinhandy.de & Sparhandy.de arbeiten massiv mit Strukturierten Daten

- TIPP: Amazon die Position 0 für das eigene Produkt zu klauen

- Beispiel reishunger.de rankt zu sehr vielen informellen Suchbegriffen zum das Thema Reis

- reishunger.de hat keine großen Produktportfolios (ca. 3-5 Reiskocher) und könnte über die Kategorieseiten mit Amazon etc. nicht mithalten

- Um als Marke relevant zu werden, arbeitet reishunger.de über mittelfristige Content-Strategien und Info- bzw. Rezeptkampagnen rund um das Thema Reis

- Starke spezifische Segmentierung des ganzen Themas sorgen für bessere Rankings in den Longtails

- Visuelle Aufbereitung der Filterfunktionen hilft den Nutzern bei der Produktfindung

- Kaufberater für „Alles“

- „Blue Ocean“-Markt selbst kreieren

- Markenname als Gattungsbegriff definieren Beispiel „Tempo, OB, Zewa“

- Whisky.de gewinnt 88% der Sichtbarkeit über Produktdetailseiten, die sehr umfangreich optimiert werden

- Detaillierte Herleitung des Geschmacks

- Umfangreiche Bewertungen

Kernaussage

Featured-Snippets, Konzentration auf die eigenen Stärken und sehr gut erstellte Inhalte im Produktbereich und im informellen Bereich bieten für Spezialhändler gute Chancen in der Suche.

16:10 Uhr „So entwickelst Du eine richtige SEO-Strategie“ von Johan von Hülsen

In seinem Vortrag ging Johan von Hülsen auf die Wichtigkeit einer langfristigen SEO-Strategie ein.

Stichpunkte

- Eine Analyse, ein Content-Plan, eine Checkliste sind keine Strategie

- Kernfrage: Welchen Nutzen biete ich Google Nutzern besser als andere Seiten?

- Wie kommt man an eine Strategie?

- Was ist unser Ziel?

- Was wollen unsere Kunden?

- Was ist unser Spielfeld?

- Was kann unsere Konkurrenz?

- Was sind unsere Fähigkeiten (oder auch nicht)?

- Gute Ziele:

- definieren das Ergebnis

- definieren ein Spielfeld

- geben eine Vorstellung von der Zielgruppe

- Sistrix Kennzahlen-Domainvergleich: „Domain.de, domain,com, domain.net, domain.info“ in den Sistrix Suchschlitz eingeben

- Fehlerbehebung ist defensiv & reaktiv >> Strategien sind offensiv und proaktiv

- Der Kern einer Strategie ist zu entscheiden, was ich NICHT tun muss

- Eine Strategie ist dann gut, wenn ich bereit bin, für meine Strategie etwas zu opfern

Kernaussage

Mit einer Strategie bewege ich mich nicht im Blindflug, sondern gehe offensiv auf meine Ziele und meine Herausforderungen zu.

16:10 Uhr – „Website-Relaunch: Mit SEO zum Erfolg!“ von Nadine Mielenz

Eine strategische Neuausrichtung, neue Märkte und modernere Technik können Gründe dafür sein, einen Website-Relaunch durchzuführen. In dieser Session erklärt Nadine die wichtigsten SEO-Anforderungen und erläutert in einem exemplarischen Projektplan das konkrete Vorgehen. Eine praktische SEO-Checkliste hilft, die häufigsten Relaunch-Fehler zu vermeiden.

Stichpunkte

- Es ist wichtig sich für den Pre-Relaunch viel Zeit zu nehmen, um sämtliche Schritte gründlich zu planen.

- Die wichtigsten Schritte

- Redirect-Mapping

- SEO-Check der Stage-Umgebung

- Radikal aufräumen ohne Angst vor Veränderungen

- SEO-Check am Relaunch-Day

- SEO-Analyse und Bestandsaufnahme nach dem Relaunch

- Keywordbasiertes Monitoring

Tool-Tipps

- Google Analytics Custom Dimensions

- Chrome Plugin Datalayer Checker

- Xpath Helper und Scraper

- Fuzzy Lookup Redirect Mapping

Kernaussagen

Die wichtigste Aussage im Vortrag von Nadine ist, dass für den Relaunch immer ausreichend viel Zeit und Ressourcen eingeplant werden sollten. Ein übereilter Relaunch ist in der Regel immer fehlerbehaftet, was zur Verschlechterung wichtiger Rankings führen kann. Ein umfassender SEO-Check der Stage ist genauso wichtig, wie die Prüfung der Live-Seite am Relaunch-Day.

16:55 Uhr „Low Budget Content Strategy – Wie Du mit wenig Ressourcen viel erreichst“ von Antigone Dyckhoff und Lena Morawietz von xpose360

Der Beitrag von Antigone Dyckhoff und Lena Morawietz geht auf Möglichkeiten ein, mit welchen gerade kleinere Unternehmen mit geringen Budgets zu guten Inhalten kommen können.

Stichpunkte

- Zielgruppe definieren (Personas erstellen) um die Inhalte richtig zu adressieren

- Konkurrenz analysieren, um bessere Inhalte als die Konkurrenz zu erstellen

- Distribution: Kanäle ausfindig machen, auf welchen man seine Inhalte verteilen möchte

- Tipps, um ressourcensparend Inhalte zu erstellen:

- Umsetzung planen und die Personen richtig zuteilen

- Content-Audit durchführen

- Themen bewerten

Kernaussage

Analyse, sorgfältige Planung, plangerichtete Ausführung. So muss man nicht blindwütig Inhalte erstellen, sondern kann zielgerichtet auf die Interessen der Zielgruppe eingehen und somit mit wenig Ressourcen mehr Ergebnisse erreichen.

17:40 Uhr „Der richtige Umgang mit SEO-Daten“ von Prof. Dr. Mario Fischer

Der Vortrag von Prof. Dr. Mario Fischer drehte sich um den richtigen Umgang mit Daten, um diese für die Optimierung seiner Seite zu nutzen.

Stichpunkte

- Daten sind das neue Öl

- Mit dem Tool KNIME können wiederkehrende Filterrungen einmalig erstellt und anschließend immer wieder ausgeführt werden

- Zwischenschritte der Filterungen werden gespeichert

- Daten können mit zusätzlichen Daten aus anderen Quellen angereichert werden

- Einfaches Zusammenklicken der Arbeitsschritte per Drag & Drop

Kernaussage

Wenn man weiß, welche Filterungen man vornehmen möchte, ist KNIME ein mächtiges Tool, um Datenanalysen vervielfacht ausführen zu können.

ToolTipp:

- KNIME

SEOkomm-Recap 2022 Salzburg von Clicks.Digital

Keine Kommentare vorhanden